1单选(1分)下列关于梯度下降(Gradient descent )法的描述错误的是?

-

A.通常会先初始化一组参数值, 在这个值之上,用梯度下降法去求出下一组的值。由于是梯度下降的,所以损失函数的值在下降。当迭代到一定程度, 损失函数取值趋于稳定,此时的参数取值即为要求得的值

-

B.其中的学习速率是模型参数,而不是超参数

-

C.学习速率的选取很关键,如果学习速率取值过大,容易达不到极值点甚至会发散,学习速率太小容易导致收敛时间过长

-

D.梯度下降是利用一阶的梯度信息找到代价函数局部最优解的一种方法

2单选(1分)在scikit-learn中,如何处理多类分类(Multi-class classification)问题??

-

A.scikit-learn可以使用one-vs-one或one-vs.-the-rest方法实现多类分类,即将多类分类问题转化为构建若干个两类的分类器

-

B.scikit-learn无法实现多类分类

-

C.scikit-learn只能用one-vs.-all实现多类分类

-

D.scikit-learn只能用one-vs.-the-rest方法实现多类分类

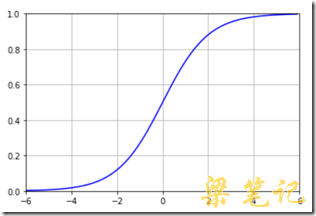

3单选(1分)?下图是哪种函数的曲线??

-

A.sigmoid

-

B.tanh

-

C.ReLU

-

D.ELU

4单选(1分)下面的一段python程序,其目的是显示下面的哪一种函数的图形?

?

import numpy as np?

import matplotlib.pyplot as plt?

plt.figure()?

plt.axis([-6, 6, 0, 1])?

plt.grid(True)?

X = np.arange(-6,6,0.1)?

y = 1 / (1 + np.e ** (-X))?

plt.plot(X, y, ‘b-‘)?

plt.show()?

-

A.tanh

-

B.ReLU

-

C.ELU

-

D.sigmoid

5单选(1分)下面关于岭(Ridge)回归的描述正确的是?

-

A.岭回归使用L1正则化

-

B.岭回归不使用正则化

-

C.岭回归使用L1+L2正则化

-

D.岭回归使用L2正则化

6单选(1分)?下面关于Lasso回归的描述正确的是?

-

A.Lasso回归使用L1正则化

-

B.Lasso回归使用L1+L2正则化

-

C.Lasso回归不使用正则化

-

D.Lasso回归使用L2正则化

7单选(1分)下面关于弹性网(Elastic net)的描述正确的是?

-

A.弹性网使用L1正则化

-

B.弹性网不使用正则化

-

C.弹性网使用L2正则化

-

D.弹性网使用L1+L2正则化

8单选(1分)对于下面的一段python程序,其目的是生成X_train的二次多项式特征,则空格内应该填入的内容为?

?

from sklearn.preprocessing import PolynomialFeatures?

X_train = [[3], [4], [5]]?

quadratic_featurizer = PolynomialFeatures( )?

X_train_quadratic = quadratic_featurizer.fit_transform(X_train)?

print (X_train_quadratic)?

-

A.degree=2

-

B.poly=1

-

C.poly=2

-

D.degree=1

9多选(1分)对某数据集进行高次多项式的回归,逐渐增加多项式的次数,如采用七次多项式回归拟合,曲线经过了所有训练集中的点,但在测试集上的R方值却变得更低了。则以下表述正确的是?

-

A.发生了过拟合较为严重(overfitting)的情况

-

B.学习得到了一个非常好的模型,其在测试集上的表现最好

-

C.发生了欠拟合较为严重(underfitting)的情况

-

D.R方值越大,则模型性能越好

10多选(1分)线性回归中计算损失函数时加入正则化项后的表达式为?

![]()

则下列说法正确的有?

?

-

A.等号右边第二项是正则化项,目的是控制过拟合现象

-

B.等号右边第一项的目标是使模型能更好地拟合训练数据

-

C.λ 是正则化参数(regularization parameter),用于控制等号右边两项的平衡

-

D.过拟合是指学习到的模型在训练集上也许误差较小,但是对于测试集中之前未见样本的预测却未必有效。或者通俗地说,模型过度学习了训练数据。